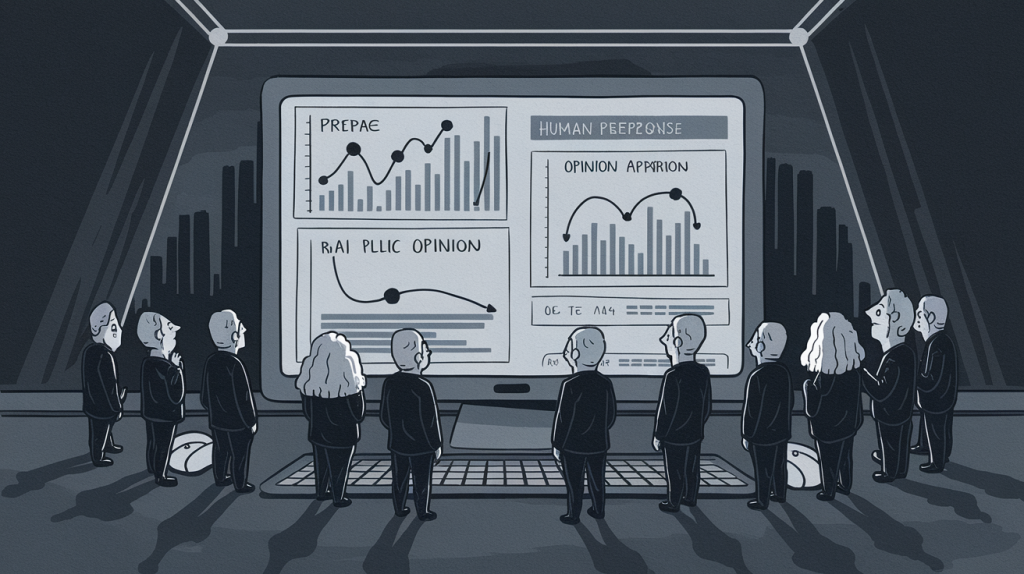

Imagine que pesquisadores querem entender o que as pessoas pensam sobre política, valores sociais e até prever resultados eleitorais, mas sem gastar milhões em pesquisas.

Então, eles decidiram colocar uma IA (neste caso, o ChatGPT-4o) para fingir ser um cidadão típico e responder a uma série de perguntas de opinião.

Neste estudo, a IA recebeu perfis demográficos (como idade, gênero, renda) e, usando esses dados, imitou como uma pessoa real dos EUA ou da China responderia a questões culturais e em quem votaria nas últimas eleições. (Link do Paper no final)

O objetivo é ver se a IA consegue prever resultados reais com base nas respostas simuladas, economizando tempo e dinheiro para a ciência social.

Se a IA conseguir, ela pode se tornar uma ferramenta poderosa para entender o público sem precisar entrevistar cada pessoa de verdade.

O artigo começa discutindo a ideia de usar modelos de linguagem (LLMs) — especificamente o ChatGPT-4o — para ver se conseguem “imitar” humanos em pesquisas de opinião. Por quê? Porque modelos desses já provaram que conseguem simular decisões humanas, então, por que não deixar a tarefa cansativa de responder pesquisas para uma IA? Seria uma economia de tempo e dinheiro absurda para cientistas sociais.

Este estudo testa a habilidade da IA para simular respostas em questões culturais e prever resultados eleitorais. E, claro, tudo isso com a promessa de que a IA possa entender tanto os Estados Unidos quanto a China, com todos seus nuances culturais, baseando-se em bancos de dados como o World Values Survey (WVS) e o American National Election Studies (ANES).

Metodologia

Como conseguiram fazer essa mágica? Eles alimentaram o modelo com perfis demográficos (como idade, estado, renda, etc.) para que o ChatGPT-4o assumisse “personas” diferentes e respondesse perguntas sobre valores, ética, e confiança. Em outras palavras, o modelo “finge” ser uma pessoa com um perfil específico para responder perguntas de opinião.

Para simular comportamento de voto, o modelo também recebeu dados das eleições passadas dos EUA e foi instruído a prever escolhas para as eleições de 2024, entre Kamala Harris e Donald Trump, como se fosse um cidadão de carne e osso. Divertido, não?

Principais Resultados (Spoiler: IA ainda é um pouco ingênua)

- Simulações de Pesquisa: O ChatGPT até se saiu bem. Ele replicou respostas humanas com precisão decente, conseguindo captar diferenças culturais básicas (EUA mais progressista, China mais conservadora em certos tópicos). Porém, ele é otimista demais quando o assunto é progresso social nos EUA. Sabe aquela pessoa que acha que o mundo está todo evoluído? Pois bem, o ChatGPT tende a superestimar a aceitação de ideias progressistas, especialmente entre americanos.

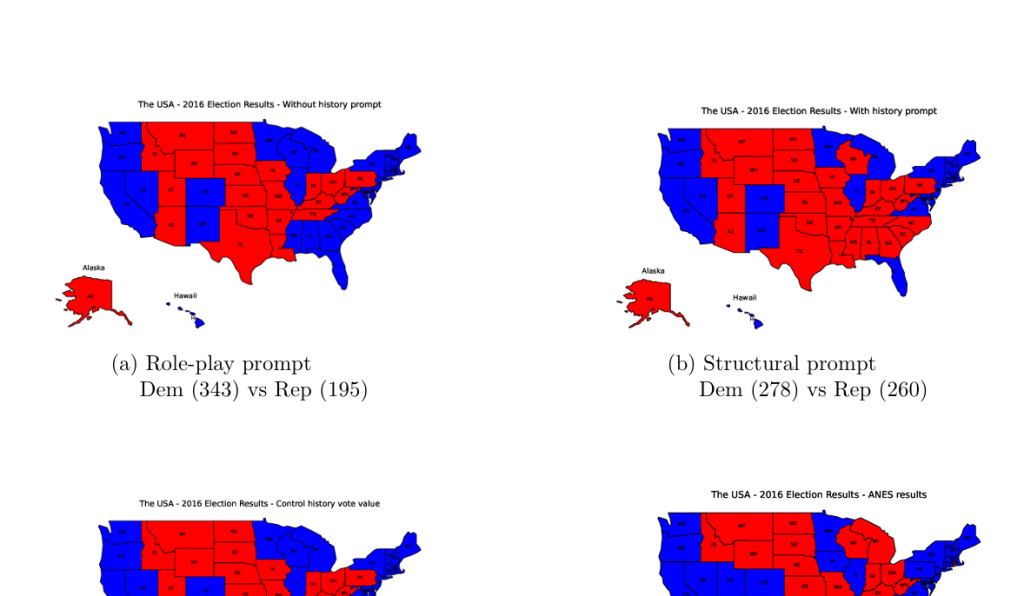

- Previsão Eleitoral: O modelo não foi terrível. Em algumas configurações, ele até previu resultados eleitorais passados com bastante proximidade, especialmente quando orientado a considerar o histórico de votos do estado em questão (leia-se: lembrar que certos estados são mais previsíveis do que uma pedra). Quando isso foi ajustado, o ChatGPT conseguiu prever corretamente alguns estados, errando em poucos.

Para a eleição de 2024, o modelo apostou que Trump ganharia, o que se tornou verdade!

Reflexões Finais (ou “Como Esperar Milagres de um Modelo de Linguagem”)

O estudo conclui que, apesar dos limites, os LLMs têm potencial para substituir pesquisas de opinião, especialmente se o custo ou a amostra forem limitantes. Mesmo com a tendência a simplificar questões complexas (algo que uma IA faz muito bem, porque nuances humanas nem sempre são o forte delas), esses modelos conseguem imitar razoavelmente as respostas humanas.

Claro, eles ainda carecem de certas “nuances” culturais — como a de aceitar ou rejeitar questões sociais de maneira contextual. E, talvez, em futuras versões, esses modelos consigam até prever tendências emergentes antes de nós. LLMs ajudando cientistas a decidir quais perguntas fazer e quais são irrelevantes. Até lá, ainda precisamos dos humanos para ver além da literalidade fria das respostas do modelo.

Ah, e um toque de realidade: sim, esses modelos são bons, mas ainda têm um longo caminho para serem “confiáveis” na mesma medida que dados reais.

Link do Estudo: 2411.01582